Mirjam BambergerChief Strategic Development Officer, AXA in Europe & Latin America

20 septembre 2022

IA : plus de puissance, mais aussi plus de responsabilité

Il y a plus de dix ans, nous constations avec surprise que les systèmes d’intelligence artificielle (IA) n’étaient pas aussi impartiaux que nous l’espérions, bien au contraire : les applications utilisant l’IA contribuent à perpétuer les préjugés existants, voire à les institutionnaliser. De là date la prise de conscience du risque de coder en dur

la discrimination dans les décisions fondées sur les données.

coder en durla discrimination dans les décisions fondées sur les données.

5 minutes

Depuis cette époque, d’importants efforts ont été déployés pour débarrasser l’intelligence artificielle des préjugés qu’elle pouvait contenir, grâce à un certain nombre de mesures. Des sauvegardes intégrées ont été ajoutées aux algorithmes pour éviter la discrimination dès la conception. La question se pose toujours de savoir ce que serait un modèle d’IA libre de toute partialité. Une interrogation qui reste pour le moins difficile à résoudre.

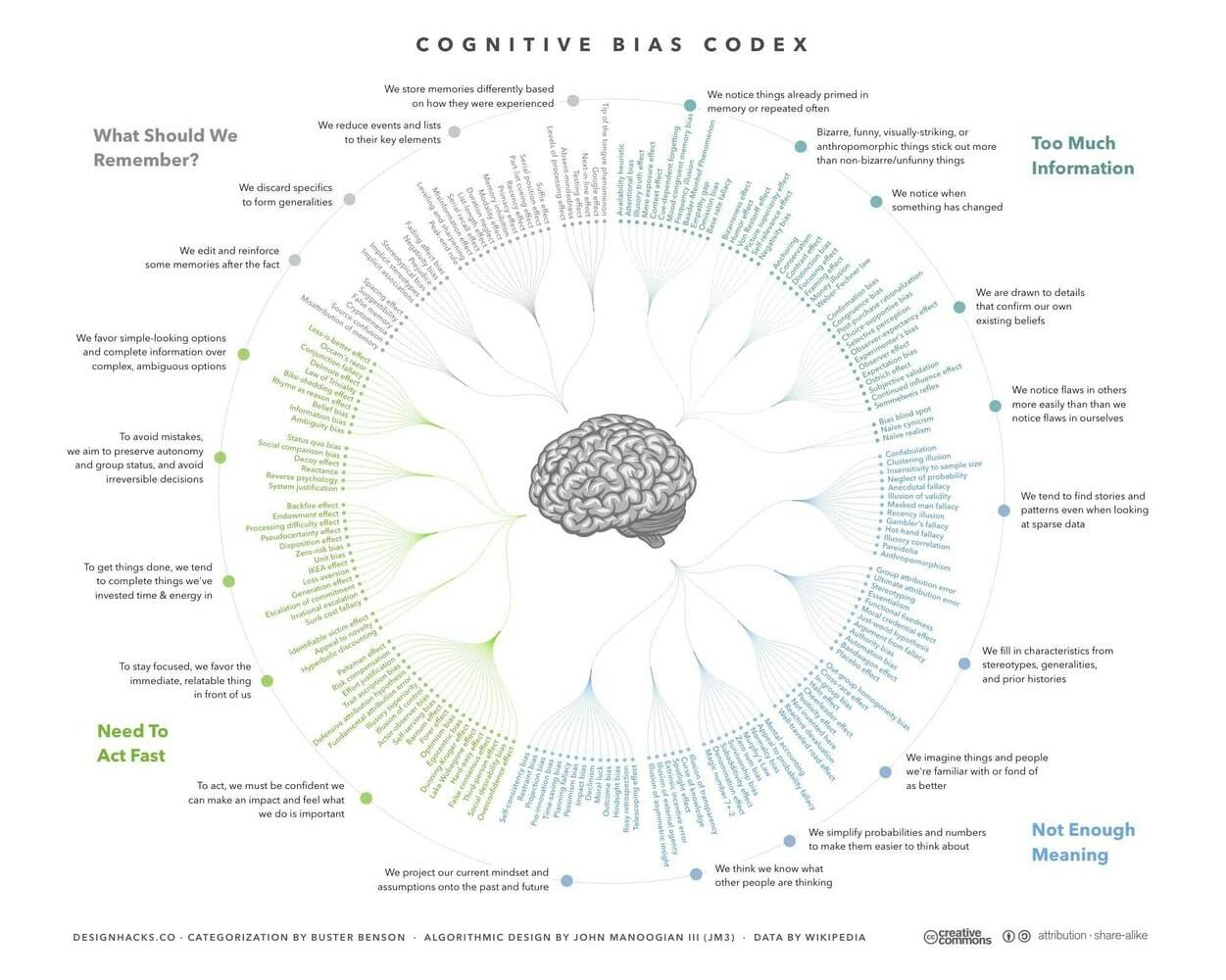

On peut néanmoins trouver un certain réconfort dans le fait que les décisions fondées sur les données sont par nature moins sujettes aux préjugés qui accompagnent souvent le jugement humain. Le schéma ci-dessous récapitule les plus de 175 biais cognitifs qui nous influencent tout au long de notre vie :

L’IA transforme le secteur de l’assurance

Tous les modèles réalistes sont sujets aux erreurs. Malgré la prudence avec laquelle un modèle est élaboré, il est inévitable qu’il conduise de temps en temps à prendre de mauvaises décisions, comme le refus d’un crédit à une personne qui y aurait droit.

En dépit de ces limites, l’IA a largement contribué à façonner le paysage de l’assurance au cours de ces dernières années, grâce aux nombreuses applications qu’elle a permises, de la détection du cancer de la peau à l’assurance des véhicules autonomes. L’IA peut considérablement améliorer l’efficacité opérationnelle des assureurs, et transformer leur façon de travailler. Voici quelques exemples :

- La reconnaissance d’images et le traitement automatique de la langue naturelle permettent de catégoriser efficacement les données non structurées des emails et d’aider les assureurs à réduire de 5 à 2 jours les délais de règlement d’une réclamation client. Dans certains cas, AXA propose même un paiement instantané si l’assuré le souhaite.

- D’autres techniques d’IA, comme le machine learning, proches de la modélisation statistique traditionnelle, permettent de proposer des formules d’assurance basées sur l’utilisation, telles que le pay-as-you-drive.

- L’IA peut également garantir un accès plus rapide aux soins médicaux et de meilleurs résultats en termes de santé. Les assurés peuvent faire contrôler leurs symptômes à un stade plus précoce et obtenir des conseils personnalisés à tout moment et où qu’ils se trouvent. L’IA est aujourd’hui reconnue comme étant extrêmement utile pour la détection des cancers de la peau, pour ne citer qu’une de ses nombreuses applications en matière de prévention sanitaire.

Plus de puissance, mais aussi plus de responsabilité

La montée en puissance de l’IA s’accompagne d’une plus grande responsabilité. AXA a donc mis en place une équipe de recherche entièrement dédiée à l’équité et à la sécurité dans l’IA, engagée de manière substantielle dans des partenariats avec des centres de recherche spécialistes de ces questions. Parallèlement, AXA a également inauguré le Responsible AI Circle

et publié un guide pratique sur l’équité dans l’IA.

Lorsqu’on jette un œil à cette étude, on réalise vite que l’équité dans l’IA est un sujet extrêmement complexe. C’est pourquoi ce guide propose des conseils concrets pour lutter contre la discrimination dès la conception et éviter le codage en dur des préjugés au sein des modèles prédictifs. Les mesures en faveur de l’équité se concentrent principalement sur la réduction des disparités, notamment entre les sexes ou entre les ethnies.

- Il n’est pourtant pas si évident d’équilibrer les erreurs entre les groupes. Cela dépend de la situation particulière, des hypothèses sur les données, de la réalité sur le terrain et des politiques telles que l’action positive.

- Et pour ne rien arranger, les critères d’équité, qui semblent obligatoires d’un point de vue éthique, se révèlent incohérents en interne. L’abondance de méthodes et de résultats contradictoires est souvent une source de frustration pour les praticiens.

- La réalité, plutôt décourageante, est que toute méthode, quel que soit le soin apporté à son application, est vouée à enfreindre au moins un critère d’équité et sera automatiquement soumise à la critique.

On peut, au minimum, se fier à un unique point de référence : lorsque la vérité ne peut être établie de manière fiable, il ne faut jamais enregistrer le résultat qu’elle a produit, mais plutôt retenir les définitions de l’équité reposant sur l’indépendance. On est ici très proche d’un concept philosophique…

L’équité inconditionnelle n’existe pas

Le partenariat avec l’équipe de recherche d’AXA a débouché sur le développement d’une Boussole de l’équité, qui s’attaque à la surabondance d’informations empêchant les professionnels de sélectionner la mesure d’équité la plus appropriée.

Grâce à la Boussole, cette sélection devient un processus transparent fondé sur une série de questions concrètes, issues d’un arbre de décision systématique. Il est ainsi plus simple et plus transparent de fournir une chaîne possible d’arguments dans une architecture de choix susceptible d’être étendue et adaptée. Ce qui ne dispense pas, toutefois, d’expérimenter plusieurs scénarios types pour tester leurs résultats.

La recherche dans le champ du machine learning équitable progresse constamment. De nouvelles définitions de l’équité vont émerger, ainsi que des applications inédites dans le monde réel. La Boussole ne constitue qu’une première étape pour contribuer au débat plus général sur l’équité, qui s’étoffera au fil du temps.

Le secteur de l’assurance repose en premier lieu sur la confiance. Il a un rôle crucial à jouer pour conduire l’IA vers le bon type d’équité, dans le cadre d’un principe général visant à traiter les clients de manière équitable, transparente et plus sûre.

Mirjam Bamberger est membre du Comité de direction des Marchés européens et d’Amérique latine d’AXA. Jusqu’en janvier 2022, elle était la CEO d’AXA Luxembourg et d’AXA Wealth Europe. Auparavant, elle a occupé divers postes en tant que membre du Conseil d’administration d’AXA Suisse, après un parcours international dans les secteurs de la haute technologie et des services financiers aux USA, en Asie et en Europe.